|

|

|

|

|

|

|

Ich habe ja ziemlich viel mit Parallelisierung gearbeitet, Threads und so, und entdecke gerade erst viel zu spät die Welt der Coroutines. Python asyncio und so. Wie angenehm das ist.

|

|

|

|

|

|

|

|

|

|

|

|

Kennt sich hier jemand gut mit "generative adversarial networks" aus?

|

|

|

|

|

|

|

|

|

|

|

GANs

Geilster scheiss. Ein NN versucht ein anderes anzulügen. Einer meiner Adjutanten ist da einigermaßen fit. Was willst denn wissen?

|

|

|

|

|

|

|

|

|

|

|

Ich träume von einem AI Bender Generator. Ich kann nämlich nicht zeichnen und habe noch einen Slot offen.

Ich habe bereits alle Bender des Forums gescraped und passend auf eine Bildgröße normalisiert. Ich hab mit PyTorch ein GAN gebaut (nach Tutorial), das konvergiert beim Training aber nicht. Um sowas zu debuggen habe ich zu wenig Ahnung, ggf. sind die Daten nicht ähnlich genug oder so.

Im Idealfall startet man nachher von einem Foto eines Menschen und landet bei einer benderisierten Form, aber ich bin inzwischen pessimistisch, ob man das überhaupt hinkriegt.

Daten und COde stelle ich gern zur Verfügung, wenn dein Kollege mal reinschauen möchte.

/e: Ich habe keine Lust großartig manuelle Bildbearbeiung machen zu müssen. Ist eher so ein kleines Nebenbei-Projekt und darf nicht viel Zeit kosten.

|

|

[Dieser Beitrag wurde 2 mal editiert; zum letzten Mal von Oli am 04.05.2020 12:06]

|

|

|

|

|

|

|

|

|

Das klingt nach sehr wenig Daten, für jegliche deep learning Modelle. Wie viele Bender sind das denn insgesamt?

|

|

|

|

|

|

|

|

|

|

|

| | Zitat von PutzFrau

Das klingt nach sehr wenig Daten, für jegliche deep learning Modelle. Wie viele Bender sind das denn insgesamt?

| |

Ich glaube so gut 1000. Das Problem ist eher, dass die zu unterschiedlich sind. Der Kopf geht ja noch, aber untenrum divergiert es schon stark. Im Idealfall würde das GAN daher den Kopf ganz ordentlich treffen und beim Rest tolerant sein, aber so gut wird man es vermutlich nicht hinkriegen.

|

|

[Dieser Beitrag wurde 1 mal editiert; zum letzten Mal von Oli am 04.05.2020 12:17]

|

|

|

|

|

|

|

|

|

Also quasi 0. Hast du ein vortrainiertes Netzwerk? Das ganze klingt nach Style Transfer. Habe aber weder von GANs noch von Style Transfer wirklich Ahnung.

|

|

|

|

|

|

|

|

|

|

|

| | Zitat von PutzFrau

Also quasi 0.

| |

Kann ich ja nicht wissen, dass AI so schlecht ist. Da scheinen ja nur Versager zu arbeiten, ich finde 1000 ganz schön viel.

Ne, ist okay, ich bin da wohl ein bisschen naiv dran gegangen.

|

|

|

|

|

|

|

|

|

|

|

Wie viele Parameter hat denn dein Modell?

Deep learning -> viel Training Daten

Wenig Daten -> random Forest, gaussian process, etc. oder ein vortrainiertes Netzwerk ggf

|

|

|

|

|

|

|

|

|

|

|

Für die Style Transfers bräuchtest du ja aber zu jedem Bender auch noch ein Attributset oder ein Foto der Person?

E: Ich hab mal für nen Hackathon ein pix2pix mit sehr wenigen Daten trainiert, da ging es aber auch um patterns mit sehr viel weniger Detail als ein Bender es so hat.

|

|

[Dieser Beitrag wurde 1 mal editiert; zum letzten Mal von RichterSkala am 04.05.2020 13:11]

|

|

|

|

|

|

|

|

|

| | Zitat von Oli

Kann ich ja nicht wissen, dass AI so schlecht ist. Da scheinen ja nur Versager zu arbeiten, ich finde 1000 ganz schön viel.

Ne, ist okay, ich bin da wohl ein bisschen naiv dran gegangen.

| |

So'n Bender der Größe sagen wir 125x125 ist ein ~50000-Dimensionaler Datenpunkt (125 * 125 * 3). Das macht quasi einen Datenpunkt pro 50 Dimensionen  . .

Für "Irgendwas mit Bildern" ist denke ich auch Vortrainierte Netze zu nehmen und ein bisschen rumzuspielen der Weg nach vorne. Erwarte dir nicht zu viel, denn GANs sind ein bisschen ein Schmarrn und die tollen Ergebnisse die du so gesehen hast sind sehr viel Handtuning. Für ein Hobby-Projekt könnte ich mir aber schon vorstellen, dass du mit auch recht wenigen Beispielen zumindest lustige Ergebnisse erzeugen kannst.

|

|

|

|

|

|

|

|

|

|

|

| | Zitat von B0rG*

Für ein Hobby-Projekt

| |

Das vergisst man natürlich immer schnell. Wenn es nicht state-of-the-art schlägt, ist es Mist.

mea culpa

|

|

|

|

|

|

|

|

|

|

|

Die Erklärung mit den Freiheitsgraden macht ergibt Sinn.

Wer malt mir dann jetzt einen Bender? WER?

|

|

[Dieser Beitrag wurde 1 mal editiert; zum letzten Mal von Oli am 04.05.2020 14:14]

|

|

|

|

|

|

|

|

|

| | Zitat von Oli

Die Erklärung mit den Freiheitsgraden macht ergibt Sinn.

| |

Cool!

Ich habe dich aber natürlich schamlos angelogen, denn Bender haben ja keine 50k Freiheitsgrade. Die Menge aller Bilder mit Bendern drauf ist sicherlich eine sehr niederdimensionale (< 100?) Mannigfaltigkeit im Pixelraum.

Das erklärt auch, warum vortrainierte Modelle überhaupt funktionieren können: Ein Netz wie ImageNet tut nichts weiter, als eine bestimmte Mannigfaltigkeit im Bilderraum zu beschreiben. Wenn du "nachtrainierst" trainierst du auf der Mannigfaltigkeit wo deutlich weniger Daten reichen können um dein Problem zu lösen.

Es erklärt auch, warum vortrainierte Neuronetze formal völliger Blödsinn sind: Keiner weiß, was für eine Mannigfaltigkeit da rauskommt oder welche Eigenschaften die hat. Wir machen irgendas mit Konvolutionen, weil das scheinbar ganz gut funktioniert. Aber im Grunde haben wir keine Ahnung.

e/ Pflichtlektüre zum State-of-the-Art.

|

|

[Dieser Beitrag wurde 1 mal editiert; zum letzten Mal von B0rG* am 04.05.2020 16:09]

|

|

|

|

|

|

|

|

|

| | Zitat von Oli

Die Erklärung mit den Freiheitsgraden macht ergibt Sinn.

Wer malt mir dann jetzt einen Bender? WER?

| |

Gibt doch immer noch die Benderforen...?

______________

https://www.quantamagazine.org/frontier-of-physics-interactive-map-20150803/

Ganz nett - das Zittern nervt aber. Und der Relativist fühlt sich ignoriert. Natürlich von einem Ami, was erwartet man da auch "fundamentale Physik" außerhalb der Hochenergie-Physik...

It's like a fingerprint, only bigger. And funnier.

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Das Beste ist doch, dass das X-Box-Gamepad unter der unterstützten HW ist

Setz dich an des Tisches Mitte, nimm zwei Bücher, schreib das Dritte!

|

|

|

|

|

|

|

|

|

|

|

SBI, danke fürs Sternen von GoogleContainerTools/distroless, jetzt habe ich mich darüber informiert!

|

|

|

|

|

|

|

|

|

|

|

| | Zitat von B0rG*

| | Zitat von Oli

Die Erklärung mit den Freiheitsgraden macht ergibt Sinn.

| |

Cool!

Ich habe dich aber natürlich schamlos angelogen, denn Bender haben ja keine 50k Freiheitsgrade. Die Menge aller Bilder mit Bendern drauf ist sicherlich eine sehr niederdimensionale (< 100?) Mannigfaltigkeit im Pixelraum.

Das erklärt auch, warum vortrainierte Modelle überhaupt funktionieren können: Ein Netz wie ImageNet tut nichts weiter, als eine bestimmte Mannigfaltigkeit im Bilderraum zu beschreiben. Wenn du "nachtrainierst" trainierst du auf der Mannigfaltigkeit wo deutlich weniger Daten reichen können um dein Problem zu lösen.

Es erklärt auch, warum vortrainierte Neuronetze formal völliger Blödsinn sind: Keiner weiß, was für eine Mannigfaltigkeit da rauskommt oder welche Eigenschaften die hat. Wir machen irgendas mit Konvolutionen, weil das scheinbar ganz gut funktioniert. Aber im Grunde haben wir keine Ahnung.

e/ Pflichtlektüre zum State-of-the-Art.

| |

Ich hätte dazu eine eher prinzipielle Frage: Was ist der mathematisch-logische Grund dafür, dass man beim Arbeiten mit NNs quasi keinerlei Forschungsarbeit leisten kann*?

* Bias. Meine Annahem ist hier: Es gibt bisher kein wissenschaftliches Verfahren, das dem, was man bisher "Science" genannt hat, entspricht. (I. e.: Es gibt kein formales Korrolar, das die Abbildung [Daten -> [nn] -> Ergebnis] hinreichend beschreibt. (Bitte, bitte: belehrt mich eines Besseren!)

Es wirkt auf mich so, als sind durch Backtracking (und andere Formalismen) Methoden da, lustige Bilder zu erzeugen. Gleihezeitig bieten einige Ideen Hinweise darauf, wie man bestimmte Verfahren in bestimmten Konfigurationen erstaunlich verschnellern kann.

Aber: Ich bin nicht in Info angetreten, um Vodoo-Motortuning auf Tensoren mit Grafikkarten zu machen. Und gefühlt dreht sich im Moment alles (nein, natürlich nicht alles) darum, wie man als so ein Auspuffschrauber in Hintertupfingen noch ein bisschen bessere Ergebnisse als die Schrauberbude im Nachbardorf erreichen kann; nur, um zu zeigen, dass man es kann.

Ich bekomme davon Pickel.

|

|

[Dieser Beitrag wurde 3 mal editiert; zum letzten Mal von Neunvoltblock am 09.05.2020 7:35]

|

|

|

|

|

|

|

|

|

Nochmal anders, um meine Punkt deutlicher zu machen: Ich stelle nicht in Abrede, dass uns NNs (in jeglicher Coleur) helfen können. Aber: Wenn wir nicht mal eine Ahnung davon haben, was da (analytisch beschrieben) vorgeht, kommt es mir so vor, als suchen wir damit Lösungen für Probleme, die - sofern hinreichend klein - von Menschen besser beanwortet werden könnten. (Siehe die Diskussion der Reeder im Bezug auf "intelligente" Tonnage- und Platzierungssysteme). Das sind schwierige Probleme (im Sinne des Informatikers). Es könnte sein, dass ein gut trainiertes Netz in 90% aller Fälle eine richtig gute Konfiguration sucht - sich dann einmal vergalloppiert, richtig daben liegt (keine Seltenheit) und sich alle fragen, warum jetzt 15 Hafenarbeiter abgesoffen sind. Geschenkt: Der Ingenieur hätte sich auch verrechnen können. Aber dann hätte man in seine Unterlagen geschaut (ja, Witz, ich weiß) und wissen können, was das Problem ist. So, wie ich NNs bisher verstehe, wäre die Reaktion: Mit vielen Minuspunkten "bestrafen" und dann: auf ein Neues.

Ohne, dass irgendein Schwanz eine Ahnung davon gewinnen konnte, was jetzt eigentlich das Problem war.*

(* Vielleicht war das einzige Problem, dass Olis dicker Vaterpenis meinte: dit läuft!)

// Schluss der Tirade: Mit erschließt sich bis heute nicht, was daran Gegenstand des Wissenschaftsbetriebs sein kann, weil das Arbeiten mit NNs jeder möglichen Deutung des Falsifizierbarkeitsprinzips widerspricht.

// // Ich bemerke gerade, dass sich mein gesamtes Geseiere in Luft auflöst, wenn man meine implizite Vorannahme, dass das Arbeiten mit NNs "harte formalistische Wissenschaft" sein sollte, fallen lässt und stattdessen akzeptiert, dass auch Engineering jedweder Art an Universitäten stattfindet. Wenn man (derzeit) NNs und ihre Kollegen als Gegenstand ingenieurstechnischer Erforschung interpretiert, an denen dann E15-Eimer wie Futti rumschrauben, ist das viel weniger böse. Vermutlich ist das Problem bei mir zu suchen, wenn ich ein Paper der theoretischen Info nicht von einem Lobo-Paper unterscheiden kann, nur weil beide gut in Tex gesetzt wurden.

|

|

[Dieser Beitrag wurde 3 mal editiert; zum letzten Mal von Neunvoltblock am 09.05.2020 7:00]

|

|

|

|

|

|

|

|

|

| | Zitat von PutzFrau

SBI, danke fürs Sternen von GoogleContainerTools/distroless, jetzt habe ich mich darüber informiert!

| |

Ah, noch jemand der sich immer freut wenn SBI was sternt.

|

|

|

|

|

|

|

|

|

|

Das freut mich

¤: Leider habe ich jetzt nicht mehr so viel mit OSS zu tun :s

|

|

[Dieser Beitrag wurde 1 mal editiert; zum letzten Mal von SwissBushIndian am 09.05.2020 9:20]

|

|

|

|

|

|

|

|

|

| | Zitat von Neunvoltblock

(I. e.: Es gibt kein formales Korrolar, das die Abbildung [Daten -> [nn] -> Ergebnis] hinreichend beschreibt. (Bitte, bitte: belehrt mich eines Besseren!)

| |

Nunja, es gibt die Verbindung: NN mit zwei layern und infinite width = Universal Function Approximator. Afair war der Beweis relativ simpel per Fouriertrafo, sodass am Ende ein Dirac delta herauskam; du ordnest also jedem Input ein Output zu. Schau mal in Hintons Standarwerk (aus dem 80er/90ern?).

Gleiches sollte für Optimizer gelten. Afaicr soll bspw. ASGD gute theoretische (Konvergenz-) Eigenschaften haben. Hat da jemand Literatur?

@Borg, Oli:

Das mit den Freiheitgraden ergibt inuitiv Sinn, jedoch sind viele SotA Modelle überparametrisiert, haben also deutlich mehr Parameter als Freiheitsgrade. Hat jemand ne gute Inuition, warum das funktioniert?

|

|

|

|

|

|

|

|

|

|

|

| | Zitat von R

@Borg, Oli:

Das mit den Freiheitgraden ergibt inuitiv Sinn, jedoch sind viele SotA Modelle überparametrisiert, haben also deutlich mehr Parameter als Freiheitsgrade. Hat jemand ne gute Inuition, warum das funktioniert?

| |

Das kann man auch in dem Mannigfaltigkeits-Setting plausibel machen: Es gibt schöne und einfache Beispiele, dass eine Mannigfaltigkeit in einen höherdimensionalen Raum einzubetten die Beschreibung vereinfachen kann. Kanonisches Beispiel ist ein 2D Kreis-Klassifikationsproblem, das in 3D per Parabel linear separierbar wird:

Die formalere Version davon heißt Kernel-Methode oder Kernel-Trick, da macht man genau das gleiche. Man kann Neuronetze mit einem linearen Output-Layer interpretieren als ein Lineares Modell mit nichtlineraen Basisfunktionen (alles bis zum vorletzten Layer), also ein "generalized linear model". Alles bis zum letzten Layer ist etwas handwavy die parametrische Form eines Kernels, der anhand der Daten gelernt wird. Ein spannendes Paper dazu.

---

Auf den Rest antworte ich noch, das ist aber eine ziemlich große Frage.

|

|

|

|

|

|

|

|

|

|

|

| | Zitat von Neunvoltblock

Ich hätte dazu eine eher prinzipielle Frage: Was ist der mathematisch-logische Grund dafür, dass man beim Arbeiten mit NNs quasi keinerlei Forschungsarbeit leisten kann*?

* Bias. Meine Annahem ist hier: Es gibt bisher kein wissenschaftliches Verfahren, das dem, was man bisher "Science" genannt hat, entspricht. (I. e.: Es gibt kein formales Korrolar, das die Abbildung [Daten -> [nn] -> Ergebnis] hinreichend beschreibt. (Bitte, bitte: belehrt mich eines Besseren!)

(...)

Ich bekomme davon Pickel.

| |

Du bekommst davon völlig zurecht Pickel. Bekomme ich auch, deshalb mache ich solchen Voodoo nicht.

Ich denke der logische Grund für fehlende harte Beweise ist in der Problemstellung von Machine Learning zu suchen. ML beschäftigt sich gerade mit den Problemen, die formal nicht gut greifbar sind und bei denen es sehr schwer fällt eine Metrik für Erfolg zu formulieren. Eine Konsequenz daraus ist, dass es eben auch keine guten Beweise für irgendwas gibt.

Nimm mathematische Optimierung als ein Beispiel: Lineare Optimierungsprobleme sind super verstanden, es gibt tolle Algorithmen und Theoreme, Konvergenz und alles ist super. Dann fragt man sich welche Dinge man noch zulassen kann, damit nicht alles explodiert. Du kannst quadratische Optimierung oder konvexe Optimierung machen und die Welt ist noch in Ordnung. Und dann kommt eine Klippe in Form von (genereller) nichtlinearer Optimierung oder ganzzahliger Optimierung. Und die besten Aussagen die wir in dem Feld machen können sind "ja, viel Glück". Man kann im Gegenteil zeigen dass alles immer beliebig schlecht sein kann. Machine Learning bewegt sich genau in diesem Feld und versucht trotzdem irgendwas zu erreichen.

Selbes Spiel in der theoretischen Informatik: Im Studium fängt man mit schön mit endlichen Automaten an und alles ist toll. Und dann kommt man irgendwann bei Turingmaschinen raus und es fällt auf, dass man plötzlich nichts mehr beweisen kann in der Allgemeinheit und dass man sogar beweisen kann dass man nichts beweisen kann und eh verloren hat (Satz von Rice z.B.). In der Algorithmik und Komplexitätstheorie macht man dann ein riesiges Theoriegebäude auf, aber auch dort gibt es die blöden Ecken. In der Praxis implementiert man dann halt doch irgendeine SAT-Heuristik die nicht nur nicht beweisbar gut sonder sogar beweisbar schlecht ist. Und benutzen tut man sie dann doch.

Machine Learning ist ein sehr junges Feld und die wissentschaftliche Seite wird total überstrahlt vom Bullshit. Das Theoriegebäude hatte noch keine Zeit irgendwie aufzuholen zu den Heuristiken und zumindest zaghaft zu fragen, wie man vielleicht doch irgendwelche Garantien geben könnte. Das beschränkt sich nicht auf neuronale Netze sondern auf so ziemlich alles das über simple lineare Modelle hinausgeht. Überleg dir mal was man bei einem normalen Regressionsproblem fordert: Du gibst mir ein paar Daten, ich soll dir die Funktion geben, die diese Daten erzeugt hat. Das kann oftmals gar nicht gehen, weil schon die Frage nicht wohldefiniert ist - gibt schließlich überabzählbar viele richtige Antworten im Reellen. Und um den Bogen noch zu spannen: Natürlich könntest du auf dieses sehr allgemeine Problem so ziemliche jedes andere Problem der Mathematik wie eben nichtlineare Optimierung oder unlösbare Fragen aus der Informatik reduzieren. Viele Leute die im ML-Umfeld unterwegs sind vermeiden es darüber nachzudenken, welche Probleme sie eigentlich lösen wollen. Sie versuchen garnicht erst wissenschaftlich zu sein und sehen offensichtliche Widersprüche nicht. Denn es ist Hype hier und man kann ja hoffen, dass Magie heraus kommt wenn man nur genügend Parameter verwendet.

Am Rande: R hat natürlich recht dass man so ein paar Sachen dann doch wieder zeigen kann, z.b. eben dass ein unendlich breites Neuronetz mehr oder weniger jede Funktion (zumindest jede mit gültiger Fouriertransformation) beschreiben kann. Einfacher Beweis: Formuliere dass ite Neuron so, dass es der ite Summand in der Fouriertransformation deiner Zielfunktion ist addiere die Neuronen. Problem ist nur: In der Praxis sind neuronale Netze natürlich endlich. Und - viel schlimmer - nur weil ein Neuronetz existiert, das deine Funktion abbildet, heißt das noch lange nicht, dass du es auch findest. Das "universal approximator"-Argument trägt in der Praxis nicht sonderlich weit, ist aber trotzdem eine schöne theoretische Erkenntnis.

---

| | Zitat von Neunvoltblock

Nochmal anders, um meine Punkt deutlicher zu machen: Ich stelle nicht in Abrede, dass uns NNs (in jeglicher Coleur) helfen können. Aber: Wenn wir nicht mal eine Ahnung davon haben, was da (analytisch beschrieben) vorgeht, kommt es mir so vor, als suchen wir damit Lösungen für Probleme, die - sofern hinreichend klein - von Menschen besser beanwortet werden könnten. (Siehe die Diskussion der Reeder im Bezug auf "intelligente" Tonnage- und Platzierungssysteme). Das sind schwierige Probleme (im Sinne des Informatikers). Es könnte sein, dass ein gut trainiertes Netz in 90% aller Fälle eine richtig gute Konfiguration sucht - sich dann einmal vergalloppiert, richtig daben liegt (keine Seltenheit) und sich alle fragen, warum jetzt 15 Hafenarbeiter abgesoffen sind. Geschenkt: Der Ingenieur hätte sich auch verrechnen können. Aber dann hätte man in seine Unterlagen geschaut (ja, Witz, ich weiß) und wissen können, was das Problem ist. So, wie ich NNs bisher verstehe, wäre die Reaktion: Mit vielen Minuspunkten "bestrafen" und dann: auf ein Neues.

| |

No true scotsmanKein ernstzunehmender ML-Forscher würde vorschlagen, ein Problem, das man auch "klassisch" lösen kann mit ML-Ansätzen zu lösen. Das wäre völlig hirnrissig: ML ist ein ziemlich großer Hammer um Struktur in Daten zu finden. Wenn man die Struktur ohnehin schon kennt und zum Beispiel in Form eines Algorithmus formulieren könnte, dann sollte man das auch tun. Unbedingt. Die Behauptung dass ML klassiche Algorithmik schlagen oder ersetzen könnte ist Blödsinn. Es ist ein Quasi unlösbares Problem ein Neuronetz zu trainieren, das lernt zwei Zahlen zu addieren. Aber bei komplexeren Problemen soll's dann plötzlich magisch möglich sein?

Trotzdem gibt es großartige Anwendungsbereiche für ML. Das wohl wichtigste ist Probleme anzugehen, für die man eben keine vollständigen Lösungen formulieren kann. Aus meiner Sicht ist ML dazu da, Lücken zu schließen zwischen Dingen, die wir schon wissen. Man sollte also wenn man vor einem Problem wie der Tonnage steht erstmal möglichst viel klassisch Lösen. Und die Löcher dann vielleicht statt mit irgendeiner Ad-Hoc Heuristik datengestützt und mit solider Statistik schließen. Denn der Vorwurf funktioniert auch nach meiner Erfahrung in die andere Richtung: Ingenieuere und auch Forscher überschätzen gerne ihre Fähigkeit, Systeme zu verstehen und zu modellieren. Nur weil eine Algorithmus auf einem Modell optimal ist muss er das nicht in der Realität sein und viele Menschen täten auch gut daran die Grenzen ihres eigenen Wissens zu kennen. Und bei allem was darüber hinausgeht kann ja ML vielleicht ein bisschen helfen.

Vielleicht weniger offensichtliche Anwendungsbereiche sind Situationen, in denen sich Zeitinvestment für eine echte Lösung nicht lohnt oder nicht leistbar ist. Oftmals ist eine "gut genug"-Lösung eben genau das, gut genug. Solange der Anwendungsbereich eng genug umrissen ist kann man ML entschieden besser automatisieren und skalieren als Ingenieure. Beispiel: Ich weiß von einem großen Autohersteller, der schon seit langer Zeit (>15 Jahre) ML verwendet um die Klimaanlage zu steuern, genauer gesagt die Magie die benötigt wird, um auf der einen Seite des Autos eine andere Temperatur zu haben als auf der anderen. Könnte man bestimmt auch mit Strömungsmgechanik lösen, aber wozu?

Und der letzte Punkt ist Personalisierung. Wenn wir eh schon bei Autos sind: Mit ML kannst du Systeme bauen, die lernen, wie speziell du als Fahrer gerne möchtest, dass dein Automatikgetriebe schaltet. Und dann kann dein Getriebe so schalten, dass du glücklich bist, maschinell gelernt. Man kann also seine Systeme um neue Qualitäten erweitern, die vorher nicht möglich waren.

---

| | Zitat von Neunvoltblock

// Schluss der Tirade: Mit erschließt sich bis heute nicht, was daran Gegenstand des Wissenschaftsbetriebs sein kann, weil das Arbeiten mit NNs jeder möglichen Deutung des Falsifizierbarkeitsprinzips widerspricht.

// // Ich bemerke gerade, dass sich mein gesamtes Geseiere in Luft auflöst, wenn man meine implizite Vorannahme, dass das Arbeiten mit NNs "harte formalistische Wissenschaft" sein sollte, fallen lässt und stattdessen akzeptiert, dass auch Engineering jedweder Art an Universitäten stattfindet. Wenn man (derzeit) NNs und ihre Kollegen als Gegenstand ingenieurstechnischer Erforschung interpretiert, an denen dann E15-Eimer wie Futti rumschrauben, ist das viel weniger böse. Vermutlich ist das Problem bei mir zu suchen, wenn ich ein Paper der theoretischen Info nicht von einem Lobo-Paper unterscheiden kann, nur weil beide gut in Tex gesetzt wurden.

| |

In einem Vortrag auf der NIPS 2017 hat ein Forscher kritisiert, dass Machine Learning wie Alchemie geworden ist (ab ca. Minute 12). Und (wieder?) mehr Wissenschaftlichkeit gefordert. Recht hat er. Ich finde es eine spannende Frage, warum auch Unis so bereitwillig an der wie du es nennst ingenieurstechnischen Forschung beteiligen. Meine These wäre es ist ein Mix aus Hype, Aufmerksamkeit und einfachen Veröffentlichungen. Die Prinzipien und das Forschungsideal werden's nicht sein  . .

|

|

[Dieser Beitrag wurde 1 mal editiert; zum letzten Mal von B0rG* am 09.05.2020 14:11]

|

|

|

|

|

|

|

|

|

| | Zitat von Oli

| | Zitat von PutzFrau

SBI, danke fürs Sternen von GoogleContainerTools/distroless, jetzt habe ich mich darüber informiert!

| |

Ah, noch jemand der sich immer freut wenn SBI was sternt.

| |

Auf jeden Fall. Gibt da noch eine andere Person, die ich aus dem RL kenne, für die es sich lohnt, ins GH Dashboard zu gehen.

Delle, Borg: Ich finde durchaus, dass engineering an der Uni gelehrt und betrieben werden sollte. Viele moderne Forschung ist ohne Engineering nicht mehr durchzuführen. Schlussendlich muss man dann akzeptieren, dass die Informatik in diesen Fällen ein Hilfsmittel für andere Bereiche ist, z.B. Biologie oder Physik. Davon ab gibt es natürlich, wie ihr schon angesprochen habt, Forschung in der Informatik selbst. Eure abschätzige Haltung ggü Engineering (in der Forschung) kann ich so nicht teilen, aber im pOT ist drastische Formulierung ja durchaus angebrachter Stil. Ein wenig nachvollziehen kann ich eure Abneigung schon, da in vermutlich 90% Prozent der Fälle an einem NN gearbeitet wird, im irgendeinen Benchmark Highscore zu schlagen, und nicht um ein wissenschaftliches Problem einer anderen Disziplin zu unterstützen. Da wird meist allerdings kein gutes Engineering betrieben, sondern eher ein wenig schlechter Python Code generiert.

Delle, ein fehlendes Theoriegebäude kann natürlich frustrierend sein. Auf der anderen Seite ist das natürlich eine tolle Möglichkeit, die Leere zu fühlen, wenn du daran Interesse hast (allerdings muss es hierfür natürlich auch jemanden geben, der bereit ist, dafür zu zahlen und auch Betreuung leisten kann).

|

|

|

|

|

|

|

|

|

|

|

| | Zitat von SwissBushIndian

Das freut mich

¤: Leider habe ich jetzt nicht mehr so viel mit OSS zu tun :s

| |

Same

|

|

|

|

|

|

|

|

|

|

|

|

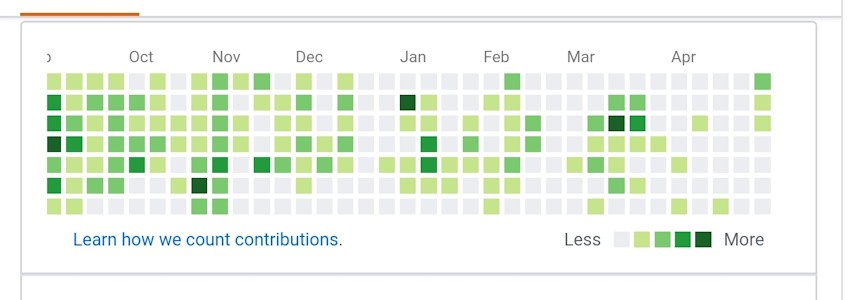

Wie nice es wäre, da etwas zu schreiben. Braucht nur ein paar Monate lang Disziplin.

|

|

|

|

|

|

|

|

|

|

|

| | Zitat von PutzFrau

Delle, Borg: Ich finde durchaus, dass engineering an der Uni gelehrt und betrieben werden sollte. Viele moderne Forschung ist ohne Engineering nicht mehr durchzuführen. Schlussendlich muss man dann akzeptieren, dass die Informatik in diesen Fällen ein Hilfsmittel für andere Bereiche ist, z.B. Biologie oder Physik. Davon ab gibt es natürlich, wie ihr schon angesprochen habt, Forschung in der Informatik selbst. Eure abschätzige Haltung ggü Engineering (in der Forschung) kann ich so nicht teilen, aber im pOT ist drastische Formulierung ja durchaus angebrachter Stil. Ein wenig nachvollziehen kann ich eure Abneigung schon, da in vermutlich 90% Prozent der Fälle an einem NN gearbeitet wird, im irgendeinen Benchmark Highscore zu schlagen, und nicht um ein wissenschaftliches Problem einer anderen Disziplin zu unterstützen. Da wird meist allerdings kein gutes Engineering betrieben, sondern eher ein wenig schlechter Python Code generiert.

| |

Oh ich habe nichts gegen Engineering und finde es gut und wichtig. Sonst würde ich ja nicht in einem Unternehmen promovieren. Ich habe ein Problem damit Engineering nicht als solches zu benennen sondern zu behaupten es wäre Wissenschaft. Und das findet leider statt.

Das Hilfsmittel-Argument verstehe ich nicht so recht glaube ich. Gerade in Naturwissenschaften ist solide und gut verstandene Statistik doch wichtig?

|

|

|

|

|

|

|

|

|

|

|

Ja, hätte ich auch schon Bock drauf, aber gerade hat Kind noch Priorität. Irgendwann in ein paar Jahren dann natürlich ein Open source Projekt mit ihm starten, aber vermutlich will er lieber was cooles machen als lame mit Papa abzunerden.

SBI, hast du schon was mit distroless deployed? Details pls

|

|

|

|

|

|

|

|

| Thema: pOT-lnformatik, Mathematik, Physik XXIII |

|